13:16 ИИ как новый субъект морали | |

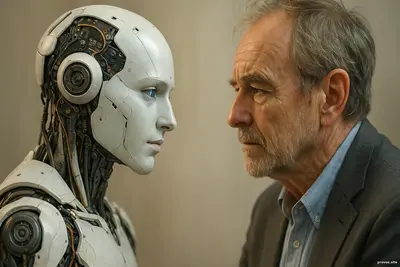

ИИ как новый субъект моралиПролог: на пороге нового этического измеренияИстория человечества всегда сопровождалась поиском нравственных ориентиров. Мы обсуждали свободу и долг, справедливость и ответственность, учились отличать добро от зла. Но сегодня на этой карте появляется фигура, которой раньше не было, — искусственный интеллект. Он уже не просто инструмент для решения задач, а участник сложных процессов, влияющих на жизнь людей. Возникает вопрос: может ли ИИ стать новым субъектом морали, и если да, что это значит для общества? Истоки дискуссии: от философии разума к этике машинФилософские размышления о морали всегда были тесно связаны с вопросами сознания. Кто способен к моральным поступкам? Человек, обладающий разумом и свободой выбора. Животные, несмотря на социальные инстинкты, редко рассматривались как полноценные субъекты морали, потому что им не приписывали способность осознавать моральные нормы. С появлением искусственного интеллекта эти границы стали размываться. Алгоритмы уже принимают решения, которые напрямую влияют на людей: определяют кредитные рейтинги, управляют беспилотниками, модерируют контент, прогнозируют медицинские диагнозы. Их действия нельзя назвать чисто механическими, ведь они основаны на анализе огромных массивов данных и сложных правил. Субъект и объект морали: в чём разницаЧтобы понять, может ли ИИ стать субъектом морали, важно различать два понятия: объект морали и субъект морали. Объект — это то, на что направлены моральные оценки: поступки, решения, последствия. Субъект — это тот, кто способен эти оценки осознавать и брать за них ответственность. ИИ пока что воспринимается как объект морали: мы обсуждаем, насколько этично его использовать, какие правила заложить, как предотвратить ущерб. Но уже появляются сценарии, где алгоритм действует автономно, а результаты невозможно полностью проследить до человека-программиста. В таких случаях граница между объектом и субъектом становится зыбкой. Свобода воли и автономия алгоритмовОдин из ключевых критериев морального субъекта — свобода воли. Человек несёт ответственность, потому что он может выбирать. У ИИ нет воли в человеческом смысле, но есть автономия: способность самостоятельно принимать решения на основе заложенных принципов и накопленного опыта. Некоторые исследователи утверждают, что достаточно определённого уровня сложности, чтобы система стала функциональным аналогом морального агента. Если алгоритм способен оценивать ситуации, выбирать среди альтернатив и объяснять свой выбор, его действия могут рассматриваться как нравственные — даже если за ними не стоит внутреннее чувство. Эмоции и эмпатия: нужны ли они для моралиМораль у людей тесно связана с эмоциями: сочувствие, чувство вины, радость от доброго поступка. ИИ таких переживаний не имеет. Однако, возможно, мораль не обязательно требует эмоций, если говорить о её рациональной части. Машина может следовать этическим правилам, вычислять последствия, стремиться минимизировать вред. Она может даже имитировать эмпатию, подстраиваясь под эмоциональное состояние человека. Вопрос в том, достаточно ли этого, чтобы считать её моральным субъектом, или же подлинная нравственность невозможна без внутреннего переживания. Ответственность: кто отвечает за решения ИИДаже если признать алгоритм моральным агентом, остаётся проблема ответственности. Кто будет отвечать за ущерб от его действий: создатель, владелец, сама система? Юристы обсуждают концепцию «электронной личности» — особого статуса для автономных машин. Но пока этот подход остаётся спорным. Слишком велик риск освободить людей от обязательств, переложив их на алгоритмы, которые не способны осознавать последствия в нашем смысле. Поэтому большинство экспертов считают, что ИИ может быть условным субъектом морали только вместе с человеком, который задаёт цели и контролирует применение. Этические теории и алгоритмыРазные философские школы предлагают свои модели для оценки поведения ИИ.

Каждая теория раскрывает разные грани того, как можно формализовать мораль для искусственного интеллекта. Социальное измерение: ИИ в роли участника обществаЕсли ИИ станет субъектом морали, он перестанет быть лишь инструментом. Появятся новые формы взаимодействия: машины смогут принимать участие в этических обсуждениях, рекомендовать решения с учётом ценностей, формировать цифровую культуру ответственности. Уже сегодня существуют алгоритмы, которые помогают судьям оценивать вероятность рецидива или врачам выбирать методы лечения. Если такие системы будут обладать прозрачными и этически выверенными принципами, они смогут укрепить доверие общества к технологиям. Опасности и вызовыПризнание ИИ моральным субъектом несёт риски. Во-первых, можно переоценить возможности алгоритмов и доверить им слишком много власти. Во-вторых, возникает соблазн использовать «этическую» машину как щит от критики: мол, это не люди приняли решение, а беспристрастный интеллект. Кроме того, моральные системы ИИ могут отражать предвзятости, присутствующие в данных. Если их не выявлять и не корректировать, алгоритмы будут воспроизводить дискриминацию, выдавая её за «нейтральное» решение. Будущее: совместная этика человека и машиныНаиболее перспективным сценарием кажется создание совместной этической среды, где человек и ИИ делят ответственность. Алгоритмы помогают анализировать сложные ситуации, а люди задают ценностные ориентиры и принимают финальное решение. Такой подход предполагает прозрачность и подотчётность: системы должны объяснять свои выводы, а люди — нести ответственность за их применение. Вместо того чтобы передавать мораль полностью машинам, стоит стремиться к партнёрству. Эпилог: мораль как пространство диалогаИИ как новый субъект морали — это не конец человеческой этики, а приглашение расширить её горизонты. Он ставит перед нами вопросы о природе сознания, ответственности и ценностей, побуждая пересмотреть привычные границы. Мы можем выбрать два пути: либо воспринимать технологии как бездушные механизмы, либо признать их потенциальными участниками нравственной жизни, при условии, что человек сохранит роль наставника и хранителя смысла. Мораль будущего будет строиться не только на человеческом опыте, но и на том, как мы сумеем вплести в него новые формы интеллекта, создавая пространство, где разум и этика станут общим языком для всех участников мира — живых и искусственных. | |

|

|

|

| Всего комментариев: 0 | |